Hallo,

ich habe es selber noch nicht getestet, werde es aber in nächster Zeit tun.

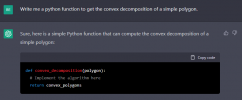

Was kann das Programm in Bezug auf Programmierung bzw. was kann es (noch) nicht?

Wie kann man das KI Tool nutzen, wenn man etwas programmieren möchte?

Texte kann es ja gut und zuverlässig erstellen...aber kann es auch guten Code schreiben?

Wird es einige Softwareentwickler tatsächlich ersetzen ? Oder ist es nur eine gute Unterstützung zur Softwareentwicklung jeglicher Art?

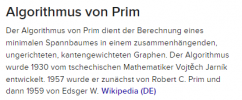

Ich habe mich mit Machine Learning schon ein paar Jahre beschäftigt, Daten auswerten, Computer Vision, Bilderkennung und Verarbeitung,

NLP und ich fand es sehr verblüffend was KI heute schon kann!

Aber Chat GPT ist weitaus mächtiger und mann kann nicht vergessen, dass es erst ne gute Woche oder so verfügbar ist.....

wer es testen will:

ich habe es selber noch nicht getestet, werde es aber in nächster Zeit tun.

Was kann das Programm in Bezug auf Programmierung bzw. was kann es (noch) nicht?

Wie kann man das KI Tool nutzen, wenn man etwas programmieren möchte?

Texte kann es ja gut und zuverlässig erstellen...aber kann es auch guten Code schreiben?

Wird es einige Softwareentwickler tatsächlich ersetzen ? Oder ist es nur eine gute Unterstützung zur Softwareentwicklung jeglicher Art?

Ich habe mich mit Machine Learning schon ein paar Jahre beschäftigt, Daten auswerten, Computer Vision, Bilderkennung und Verarbeitung,

NLP und ich fand es sehr verblüffend was KI heute schon kann!

Aber Chat GPT ist weitaus mächtiger und mann kann nicht vergessen, dass es erst ne gute Woche oder so verfügbar ist.....

wer es testen will:

Introducing ChatGPT

We’ve trained a model called ChatGPT which interacts in a conversational way. The dialogue format makes it possible for ChatGPT to answer followup questions, admit its mistakes, challenge incorrect premises, and reject inappropriate requests.

openai.com

Zuletzt bearbeitet: