Hallo,

da es den Forenabschnitt "Sonstiges" ist der Desktopversion des Forums nicht zu geben scheint, poste ich mal hier.

Ich bearbeite gerade mein erstes Übungsblatt für ADS und es geht grundlegend mit Komplexitätsklassen für Zeit und Speicherbedarf los.

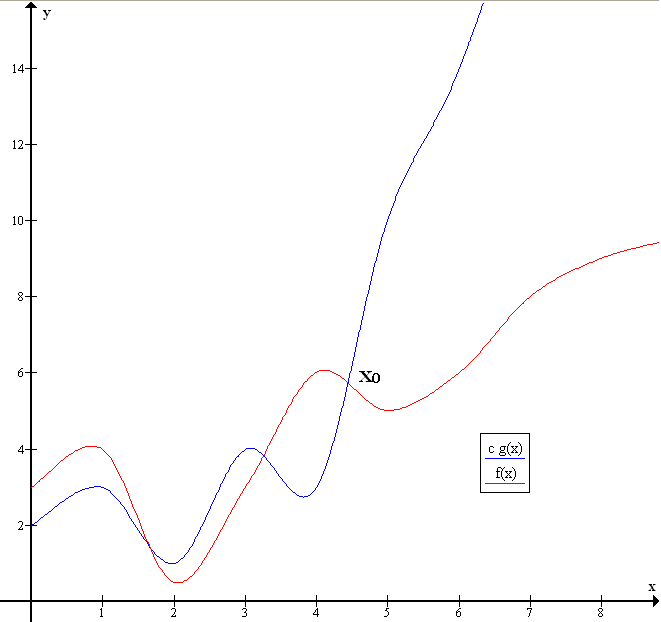

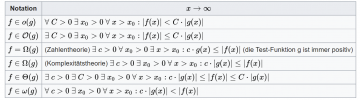

In der 1. Aufgabe soll ich die kleinstmöglichen Komplexitätsklassen ( O(n), O(n²) etc.) angeben. Ich habe dazu diverse Funktionen bekommen, die sich im wesentlichen aus der Termen mit ganzrationalen Brüchen, log und Wurzel und noch ein paar mit trigonomial Ausdrücken zeigen.

Ich kenne das Master Theorem und kann das denk ich recht gut anwenden. Wie aber geh ich hier vor? Ebenfalls nach der höchsten Potenz Ausschau halten und gegebenfalls Wurzeln in Potenzen umbauen? Und was ist hier mit kleinstmögliche gemeint?

Kann wer was dazu sagen?

Danke

Lou

PS: Kann ich hier unkompliziert MatheFormatierung einfügen?

da es den Forenabschnitt "Sonstiges" ist der Desktopversion des Forums nicht zu geben scheint, poste ich mal hier.

Ich bearbeite gerade mein erstes Übungsblatt für ADS und es geht grundlegend mit Komplexitätsklassen für Zeit und Speicherbedarf los.

In der 1. Aufgabe soll ich die kleinstmöglichen Komplexitätsklassen ( O(n), O(n²) etc.) angeben. Ich habe dazu diverse Funktionen bekommen, die sich im wesentlichen aus der Termen mit ganzrationalen Brüchen, log und Wurzel und noch ein paar mit trigonomial Ausdrücken zeigen.

Ich kenne das Master Theorem und kann das denk ich recht gut anwenden. Wie aber geh ich hier vor? Ebenfalls nach der höchsten Potenz Ausschau halten und gegebenfalls Wurzeln in Potenzen umbauen? Und was ist hier mit kleinstmögliche gemeint?

Kann wer was dazu sagen?

Danke

Lou

PS: Kann ich hier unkompliziert MatheFormatierung einfügen?